2024.02.07_学习日记

天气:雾

学习地点:家

学习时长:5h

学习内容

- bagging\boosting(集成方法)

bagging是从原始样本集抽取不同的样本集,然后每个样本集得到不同的模型。分类问题就采用投票的方式得到最后的结果,回归问题就用均值得到结果。这里面所有模型的重要性相同。

boosting跟bagging相似,但是不同的样本集权重不同。

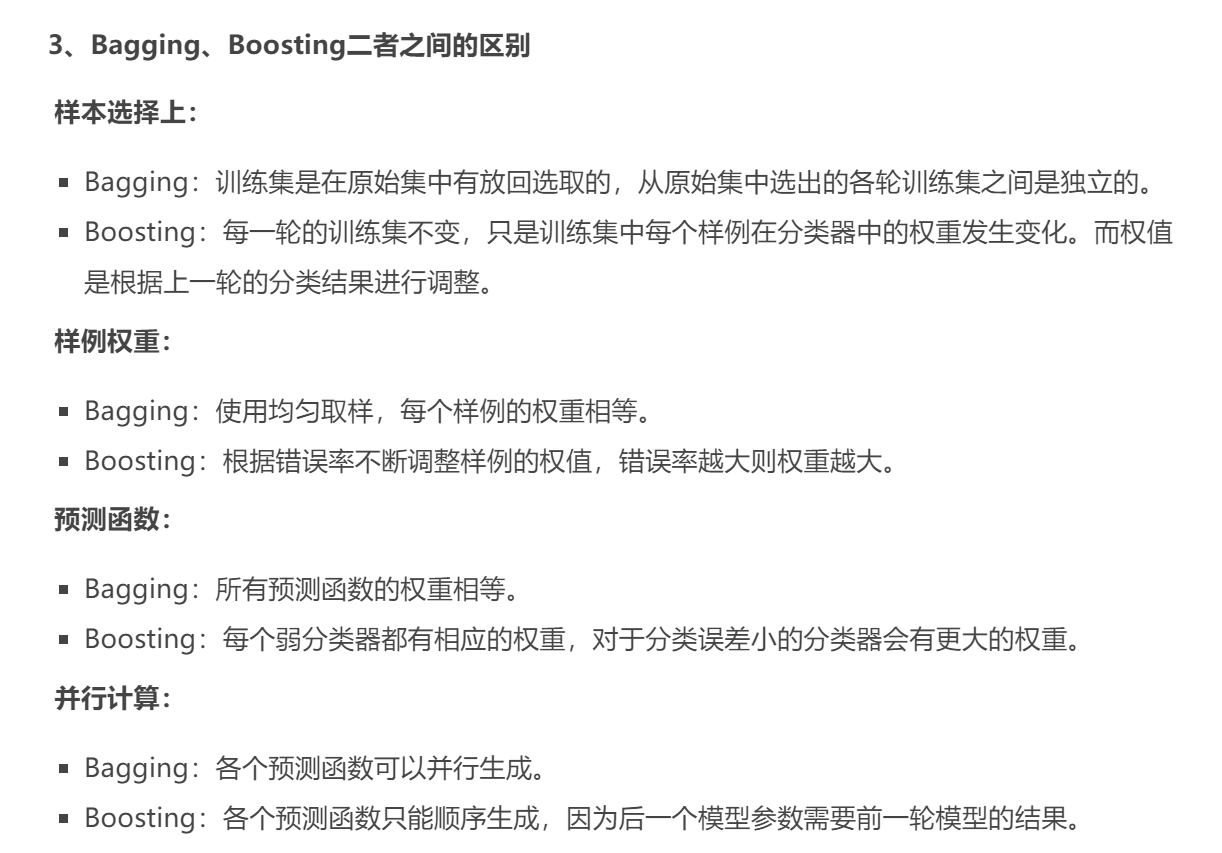

区别:

- Adaboost

代码很简单 - 回归

LWLR局部加权线性回归,过小的核可能导致过拟合现象,即训练集表现良好,测试集表现就渣渣了。 - 岭回归

缩减方法(逐步线性回归或岭回归),就是将一些系数缩减成很小的值或者直接缩减为0。这样做,就增大了模型的偏差(减少了一些特征的权重),通过把一些特征的回归系数缩减到0,同时也就减少了模型的复杂度。消除了多余的特征之后,模型更容易理解,同时也降低了预测误差。但是当缩减过于严厉的时候,就会出现过拟合的现象,即用训练集预测结果很好,用测试集预测就糟糕很多。

预测乐高玩具套件的价格:

可以用岭回归交叉验证,可以看到哪些特征是重要的,然后预测的时候可以就用这些特征预测,回归与分类的不同点在于,前者预测连续类型变量,而后者预测离散类型变量。 - 动态规划

建表,找表依赖关系,找可以填的base值,然后依次填表。